¿Qué es Spark?

Apache Spark es un framework de procesamiento en modo código abierto desarrollado en 2009 en el AMPLab de la Universidad de California en Berkeley. El framework fue donado a la Apache Software Foundation en 2013. Spark permite realizar de manera rápida análisis de datos y modelos de desarrollo. Spark permite acceder al conjunto de datos evitando la necesidad de realizar submuestras tal y como hacen entornos tipo R. También da psoporte a trabajar en streaming lo que permite construir modelos en tiempo real con todo el conjunto de datasets. Si la tarea es demasiado grande para un único servidor, la arquitectura permite dividir la tarea en piezas más manejables según las capacidades de hardware que dispongamos en cada momento. Esas piezas de tareas divididas funcionan en modo en memoria a lo largo del cluster de servidores, aprovechando la memoria disponible conjunta del total de máquinas. El procesamiento de Spark está basado en su conjunto elástico de datos distribuidos (Resilient Distributed Dataset o RDD).

¿Porqué Spark se ha impuesto para procesamiento de big data?

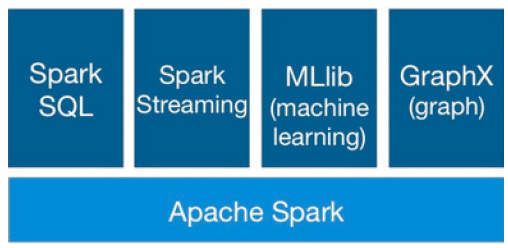

En los últimos dos años Spark se ha puesto de moda en el mundo del big data debido a su rendimiento computacional y la amplia gama de librerías como Spark SQL, Spark Streaming, MLlib (machine learning) y GraphX.

Spark SQL permite el procesamiento de datos estructurados. Permite trabajar con DataFrames, una abstracción de programación, y también puede actuar como motor de consultas SQL distribuido. Spark Streaming permite realizar un procesamiento de datos en tiempo real, escalable, de alto rendimiento, y con tolerancia a fallos. El objetivo de MLlib es hacer práctico, escalable y fácil el machine learning. Consiste en un conjunto de algoritmos y utilidades comunes, como clasificación, regresión, clustering, filtrado colaborativo y reducción de dimensionalidad. GraphX es el componente de Spark para visualizaciones y cálculo gráfico en paralelo.

Spark SQL permite el procesamiento de datos estructurados. Permite trabajar con DataFrames, una abstracción de programación, y también puede actuar como motor de consultas SQL distribuido. Spark Streaming permite realizar un procesamiento de datos en tiempo real, escalable, de alto rendimiento, y con tolerancia a fallos. El objetivo de MLlib es hacer práctico, escalable y fácil el machine learning. Consiste en un conjunto de algoritmos y utilidades comunes, como clasificación, regresión, clustering, filtrado colaborativo y reducción de dimensionalidad. GraphX es el componente de Spark para visualizaciones y cálculo gráfico en paralelo.

Ventajas Spark

Hasta ahora no existía un framework de procesamiento de datos unificado que diera respuesta a todas las demandas. Esta es la ventaja principal de Spark, que permite a las áreas críticas de las empresas beneficiarse de las ventajas que ofrece este marco único. Veamos algunas:

Analítica avanzada

Spark ofrece un framework para realizar análisis avanzados out-of-the-box. Incluye como hemos visto una herramienta para realizar queries rápidamente, una librería de aprendizaje de máquina, un motor de procesamiento de gráficos, y un motor de análisis en datos en en streaming. No hay necesidad de implementar otras herramientas via MapReduce, Spark ya ofrece librerías preconfiguradas, que son más fáciles y rápidas de usar.

Simplicidad

Una de las primeras críticas que se hizo a Hadoop fue que era difícil de usar, requería que los usuarios comprendieran una variedad de complejidades como MapReduce o programación avanzada en Java. Aunque se ha simplificado a la vez que se hacía más potente con cada nueva versión, la queja ha permanecido. Spark fue creado para ser accesible a cualquiera con conocimientos en bases de datos y algo de habilidad de scripting en Python o Scala.

Resultados más rápidos

A medida que el ritmo de los negocios se acelera, también la necesidad para el análisis en tiempo real. Spark ofrece procesamiento in-memory en paralelo, consiguiendo unos resultados múltiples veces más rápidos que otras soluciones que requieren acceso a disco. Los resultados al instante eliminan los retrasos que pueden ralentizar los procesos de negocio e incrementar la analítica necesaria. Otras compañías han creado aplicaciones complementarias para Spark que facilitan una gran cantidad de ampliaciones y mejoras. Lo que se traduce en que los analistas pueden trabajar de forma iterativa, afinando las respuestas más precisas y más completas.

Spark permite a los profesionales de la empresa hacer lo que se supone que deben hacer.

Sin preferencia por distribuidores Hadoop

Todas las distribuciones Hadoop dan soporte ahora a Spark por una razón muy sencilla: Spark es agnóstica en cuanto al distribuidor, lo que significa que el cliente no está atado a un determinado proveedor. Gracias a su naturaleza open-source, las empresas son libres para crear una infraestructura analítica basada en Spark sin necesidad de preocuparse qué ocurrirá si cambian de proveedor Hadoop en un futuro. Si hacen el cambio, pueden llevarse sus analíticas.

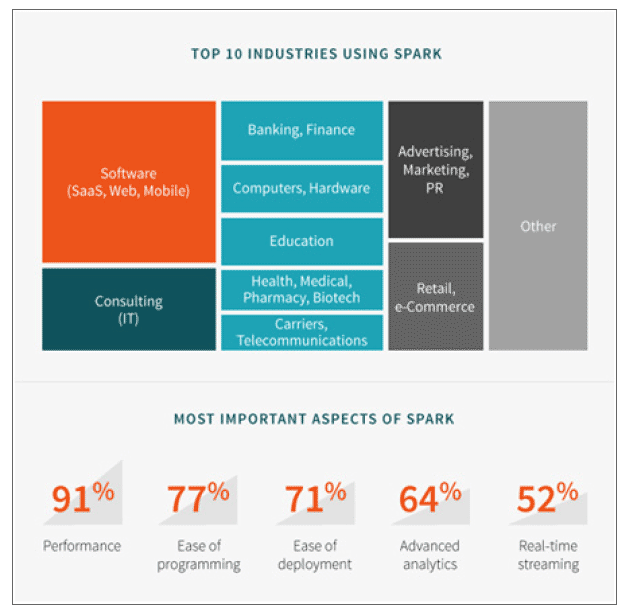

Encuesta del ecosistema Spark

Recientemente Typesafe realizó una encuesta sobre el ecosistema Spark. Algunas claves extraídas del informe sobre cómo se están realizando despliegues Spark en proyectos en las empresas:

[tie_list type=»lightbulb»]

- En cuanto al almacenamiento de datos, un 62% de los encuestados utilizaban HDFS. Casi la mitad, el 46%, estaban utilizando algún tipo de base de datos. El 41% usaba Kafka, y el 29% estaba usando Amazon S3.

- En cuanto a gestión del cluster, el 56% utilizaban una sola instancia de Spark- Un 42% usaban YARN, y el 26% Apache Mesos.

- En cuanto a lenguajes, un 88% usaba Scala, un 44% Java, y un 22% Python.

- En cuanto a roles de usuario, una encuesta de Databricks realizada en 2015, un 41% de los encuestados se consideraba ingeniero de datos, un 22,2% científico de datos, un 17,2% arquitectos de datos, un 10,6% tenían un perfil de gestión de negocio, y un 6,2% estaba relacionado con el entorno académico.

[/tie_list]

Spark, el entorno big data de moda

La cantidad global de datos generados cada día es de 2,5 exabytes. El mercado de big data ha sobrepasado los 27.000 millones USD. Spark es una arquitectura de computación expresamente diseñada para este tipo de crecimiento. En Junio de 2015 IBM anunció que iba a formar un millón de data scientists e ingenieros en Spark. Otras razones por las que la trayectoria ascendente de la arquitectura:

Reinventando MapReduce

Comparándolo con MapReduce, Spark ofrece mayor flexibilidad. MapReduce solamente permite dos operaciones: mapear y reducir. Spark ofrece más de 80 operaciones de alto nivel. MapReduce es ineficiente al manejar determinados algoritmos, por lo que se desarrollaron alternativas para manejar herramientas analíticas interactivas. Spark destaca en la programación de modelos que incorporan iteraciones, interactividad, y streaming.

Uso de HDFS

Spark permite (aunque no obliga a) usar HDFS (Hadoop File System).

Uso de YARN

Spark permite usar el gestor de cargas de trabajo YARN de Hadoop.

Uso eficiente de la memoria

El modelo Hadoop se basa en un modelo en dos etapas MapReduce en disco. Spark es un modelo multi-etapa con primitivas en memoria, lo que permite un tiempo de respuesta de hasta 100 veces para determinadas configuraciones. al permitir a los programas cargar los datos en la memoria del cluster y hacer las consultas repetidamente, Spark está especialmente preparado para algoritmos de machine learning. En estudios de benchmark recientes referentes a almacenamiento en memoria (como instancias HDFS sin disco) Spark superaba a Hadoop en 20 veces.

Spark ofrece workflows de analíticas

Gracias a su librería para machine learning (MLlib), al API para gráficos analíticos (GraphX), el soporte de queries basadas en SQL, y aplicaciones en streaming, Spark se convierte en una plataforma convergente cuando necesitamos hacer analítica seria en big data y usar el código que tengamos escrito en cualquiera de los componentes para hacer nuestro propio workflow analítico.

What do you think?

buena pagina pero quiero saber como o donde comprarlo y ocuparlo en el movil

Desde Baoss ofrecemos productos y soluciones a medida para empresas y organizaciones. Para particulares puedes buscar en internet por herramientas de análisis de datos y podrás acceder una serie muy variada de oferta dependiendo tus necesidades y presupuesto.

El avance tecnológico es indudablemente de gran ayuda en los diferentes sectores o áreas de la vida real. Me gustaría saber el uso del big Data en las exploraciones mineras,dando un ejemplo real.

Estimado Alberto, gracias por tu comentario. Para analizar un caso real en el sector que comentas puedes ponerte en contacto con nosotros a través del formulario que encontrarás en la página de Contacto y con mucho gusto estudiaremos tu caso.

Creo que también ha sido muy útil en las predicciones de las ocurrencias de eventos de la naturaleza, como los huracanes, los terremotos, maremotos, las trombas marinas, incluso creo que con los suficientes datos podrán predecir los incendios forestales

Hola muy buen día, soy estudiante de Ciencias de la Tierra y el Big Data es uno de los temas que más se están manejando en la actualidad, pues sus aplicaciones son realmente ilimitadas- Me gustaría que me compartieran un poco de sus conocimientos a manera breve y general sobre las aplicaciones en casos de la vida real que se estén llevando a cabo en sectores como la industria minera, la industria petrolera y algunas otras aplicaciones en la solución de problemas ambientales.

.Espero me puedan compartir un poco de su información, sin duda sería interesante aplicarlo en la solución de problemas de mi área de estudio y de la misma forma compartirlo con mis colegas de profesión, pues es necesario divulgar estos conocimientos para que lleguen a más personas y comiencen a tomarse en cuenta en otras áreas de estudio. Saludos y gracias por su tiempo

Gracias Emiliano por tu comentario y por seguirnos. Iremos publicando nuevos artículos. Suerte en tu carrera!

I am really enjoying the theme/design of your site.

Do you ever run into any browser compatibility issues?

A few of my blog readers have complained about my site not

operating correctly in Explorer but looks great in Firefox.

Do you have any tips to help fix this problem?

Not at all. Thanks!

Hay algún municipio que utilice el big data y que haya mejorado el servicio a la ciudadanía, me podrías compartir esa información

Prácticamente todos los municipios grandes lo llevan utilizando hace años para medir y prever niveles de contaminación, tráfico, turismo, y muchos casos mas.

A través de la Big Data, existe el más pavoroso riesgo, todo lo anterior obvia el mayor peligro implícito en este tipo de tecnologías que hoy por hoy están fuera de control. La posibilidad de controlar, manipular, inducir, orientar a poblaciones enteras en pos de obtener objetivos perversos dirigidos por poderes fácticos ubicados en cualquier parte del mundo. Estamos iniciando un proceso que más temprano que tarde terminará con las democracias occidentales.

[…] http://www.baoss.es/10-ejemplos-usos-reales-big-data/ […]

[…] conclusiones obtenidas del estudio masivo de datos ya están revolucionando muchos campos que nada tienen que ver con la empresa o el retail. Por ejemplo: Google y el CDC, el centro de control de enfermedades de Estados Unidos, se aliaron […]

[…] Fuente de información: https://www.baoss.es/10-ejemplos-usos-reales-big-data/ […]

[…] Referencias: wikipedia.org, pauhortal.net, baoss.es, powerdata.es, mintic.gov.co […]

[…] Y, como decíamos, esta tendencia no solo puede ayudarnos a mejorar las ventas en nuestros negocios, si no que, aplicada a otros sectores, puede mejorar nuestra calidad de vida. La administración pública, el turismo, la sanidad, hacienda… todos ellos disponen de grandes almacenes de datos que con un buen análisis y el uso de las herramientas adecuadas pueden aportar importantes soluciones. Hay ya muchos ejemplos reales de uso de Big Data en este sentido: se integran datos de historiales clínicos con otros de redes sociales para detectar brotes de gripe en tiempo real; se usan datos de tráfico rodado para mejorar la movilidad en las ciudades; o el uso de datos personales (a veces trascendiendo el derecho a la privacidad) para evitar ataques terroristas. Ver más ejemplos aquí. […]

[…] https://www.baoss.es/10-ejemplos-usos-reales-big-data/ […]

[…] https://www.baoss.es/10-ejemplos-usos-reales-big-data/ […]

[…] EJEMPLOS: Marketing y ventas son quizá las áreas de mayor aplicación de big data en la actualidad, los datos que se encuentran sirven para entender mejor al cliente. en la salud pública La capacidad de procesamiento de plataformas de análisis de big data nos permite ya descodificar cadenas enteras de ADN en cuestión de minutos y permitirá encontrar nuevos tratamientos y comprender mejor las enfermedades, sus desencadenantes y los patrones de propagación mejoramiento de la seguridad: El sistema de IA creado en el MIT predice el 85% de los ciberataques. Otros ejemplos: Las fuerzas policiales están empezando a utilizar herramientas de big data para dar con criminales e incluso prevenir actividades criminales.Otro ejemplo que lleva años empleándose es en la detección de transacciones fraudulentas con tarjetas de crédito. https://www.sas.com/es_pe/insights/big-data/what-is-big-data.html https://xombit.com/2015/11/big-data-procesar-informacion http://www.iic.uam.es/innovacion/big-data-caracteristicas-mas-importantes-7-v/ https://www.baoss.es/10-ejemplos-usos-reales-big-data/ […]

[…] Lee más ejemplos de Big Data Analytics eficaz aquí. […]

[…] El uso de Big Data: El uso de Big Data nos facilita muchísimo la conexión con posibles compradores y sus intereses, esto nos ayuda a ser […]

Comments are closed.