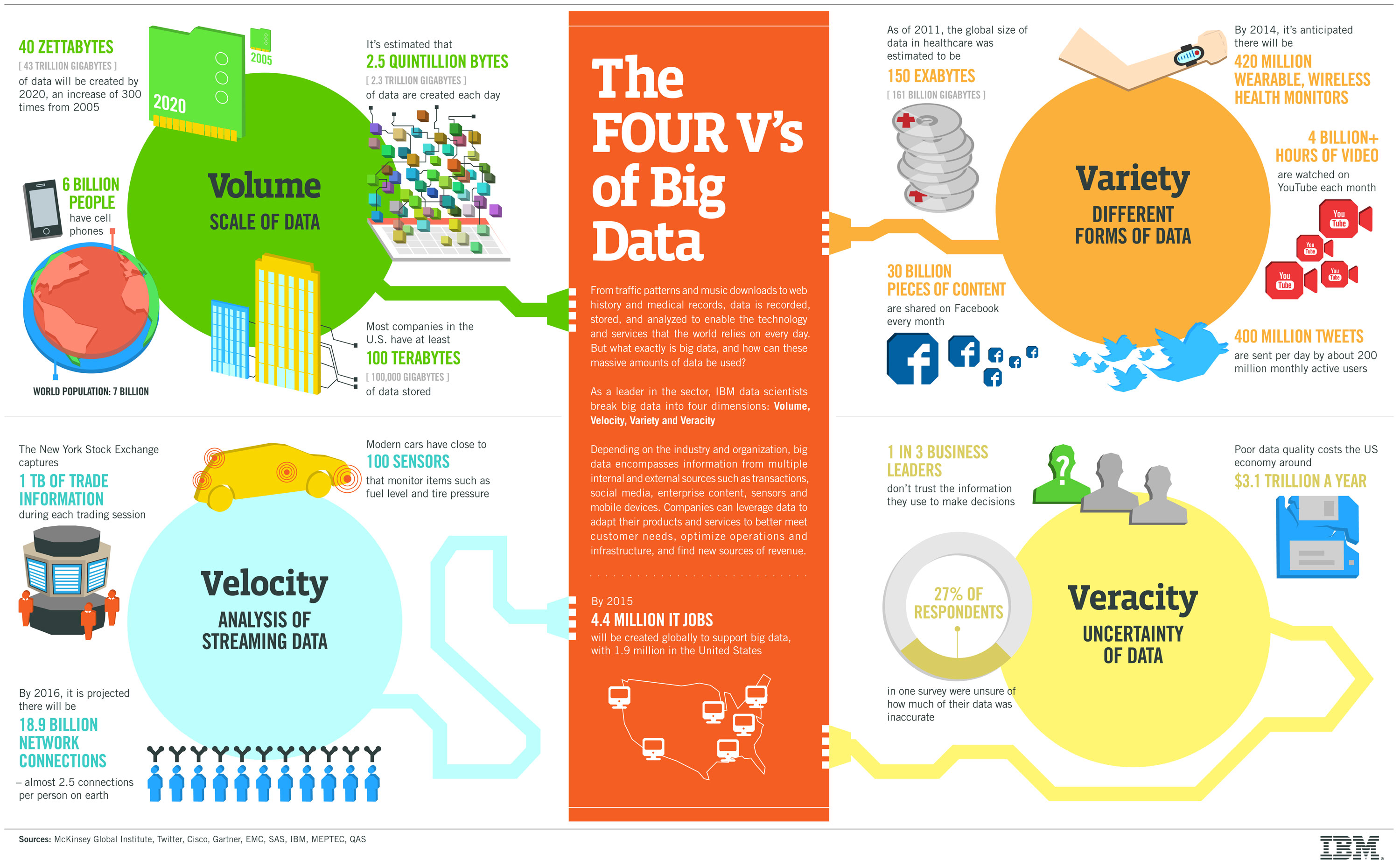

A pesar de que puede haber cierta controversia en cuanto a qué puede considerarse Big Data y qué no, prácticamente todos los analistas profesionales y especialistas coinciden en que el Big Data tiene cuatro dimensiones con unas características propias: volumen, variedad, velocidad y veracidad. Esta infografía explica y da ejemplos de cada una de las características, público…

Al hacer clic el enlace descargar infografía en alta resolución.

Al hacer clic el enlace descargar infografía en alta resolución.

Volumen

El big data implica un volumen enorme de datos. En un inicio los datos eran creados por los propios empleados pero ahora que los datos son generados automáticamente por máquinas, redes e interacciones personales en sistemas como redes sociales los volúmenes a analizar son masivos. La tecnología para guardar y procesar ha avanzado paralelamente por lo que el mayor problema ahora no es tanto el tamaño como otras dimensiones como la veracidad.

Variedad

La variedad se refiere a las diferentes fuentes y tipos de datos tanto estructurados como no estructurados. Hace pocos años los únicos datos que se almacenaban eran de fuentes como hojas de cálculo y bases de datos. Ahora, los datos llegan en la forma de emails, fotos, videos, sistemas de monitorización, PDFs, ficheros de sonido, … Esta variedad en datos no estructurados crea problemas de almacenamiento, minería de datos y análisis de la información. IBM dispone de nuevas herramientas que están ayudando a las empresas con los retos de los nuevos tipos de datos analizables, incluyendo la variedad.

Velocidad

La velocidad en big data se refiere al ritmo en que los datos de entrada fluyen desde las diversas fuentes como procesos de negocio, máquinas y sensores, redes sociales, dispositivos móviles, etc. El flujo de datos es masivo y continuo. Estos datos recogidos en tiempo real permiten ayudar a investigadores y organizaciones a la hora de tomar decisiones aportando valiosa información que suponen ventajas competitivas estratégicas. El ROI (retorno en la inversión) está asegurado para las empresas que sepan manejar esa velocidad. Muchas empresas comienzan con muestras de datos para ir comprendiendo el valor aportado y van ampliando a medida que se van viendo los resultados.

Veracidad

La veracidad en el big Data Veracity se refiere al sesgo, el ruido y la alteración de datos. Los responsables del proyecto big data han de preguntarse honestamente si los datos que se almacenan y extraen son directamente relacionados y significativos al problema que se trata de analizar. Esta característica puede ser el mayor reto cuando se comparan con otras como el volumen o la velocidad. Cuando se valore el alcance en su estrategia de big data es necesario contar en el equipo con socios imparciales que ayuden a mantener los datos limpios y asegurarse que los procesos no acumulen “datos sucios” en sus sistemas.

Al igual que la veracidad de datos se ha de comprobar la validez en la información, ¿son los datos correctos y precisos para el uso previsto? Este aspecto es clave para poder tomar las decisiones correctas.

Por último, hay quien añade una V más a las dimensiones, la volatilidad. Se refiere al tiempo durante el cual los datos recogidos son válidos y el tiempo que deben permanecer almacenados. En esta nueva era de aluvión de datos en tiempo real es necesario determinar hasta qué punto los datos son válidos y en qué momento dejan de ser relevantes para su estudio analítico.

[…] Fuente: Artículo prometeusgs.com, Artículo BAOSS […]